Vis ma vie de référenceur : 18 mois de dingue !

Je suis référenceur et en quelques mots, je vais essayer de vous faire vivre les dix-huit derniers mois à travers le prisme SEO.

Cette année fut bien difficile pour de nombreux référenceurs, éprouvante même. Quelques référenceurs chevronnés semblaient près de jeter l’éponge !

Le moteur de recherche Google a bien entendu évolué via (notamment) deux mises à jour majeures, mais c’est surtout la communication de l’ogre américain qui s’est musclée.

N’allez pas croire que derrière les noms de code saugrenus « Panda » et « Penguin » (manchot) qui affublent ces nouveautés d’algorithmes se cachent de saines intentions.

Avant de mettre en ligne ses modifications, Google annonce, prévient, évangélise ou plutôt menace !

Voici ce que Matt Cutts déclarait à un référenceur souhaitant connaître la date du prochain châtiment : « You don’t want the next Penguin update. »

Avant d’analyser cette communication, découvrez plus en détail cette petite ménagerie.

Google Panda

Panda est une mise à jour ciblant les pages de qualité médiocre proposant une faible valeur ajoutée aux internautes.

La première version est apparue début 2011 et nous en sommes à plus de vingt mises à jour depuis lors, la dernière ayant eu lieu début novembre.

Les sites d’intermédiation ont été touchés significativement, avec en tête, les comparateurs de prix. Sauf Google Shopping, bien entendu, qui aurait même vu son trafic augmenter. Les sites qui génèrent des pages avec peu de contenu original ont eu quelques frayeurs également.

Cette mise à jour a été incroyablement favorable aux sites e‑commerce que j’audite. Évidemment, lorsque les comparateurs ne sont plus dans les pages de résultats, il y a plus de place pour les autres.

Le déploiement a eu lieu dans la nuit de vendredi à samedi. Le 12 août 2011 est un très bon souvenir. J’étais euphorique tout le samedi et j’ai passé mon lundi à envoyer de bien jolis reportings aux clients comme celui ci-dessous.

Google Penguin

Penguin est une mise à jour ciblant les pages sur-optimisées pour le référencement.

C’est surtout cette mise à jour qui a fait très peur. Elle fut précédée d’une campagne de communication hallucinante doublée par des articles de référenceurs (dont je fais partie) attisant le feu à coup d’annonces apocalyptiques.

Nous avons été nombreux à ne plus supporter cette attente et finalement à finir par espérer une mise en ligne rapide de cet UPDATE afin « d’en finir ».

Au final, c’est avant tout les véritables bourrins qui ont été touchés (mais pas tous, loin de là) et surtout les petits sites ultra-optimisés pensés uniquement pour le SEO.

Je n’ai pas vu d’importantes variations le jour du déploiement : OUF ! Toutefois, j’ai constaté la chute de quelques rares mots clés trop optimisés en netlinking plusieurs semaines ou mois après, surtout pour les « petits » sites n’ayant que du trafic SEO.

L’objectif de Google n’était pas de modifier énormément ses résultats, qui sont globalement très pertinents, mais avant tout de faire peur. Et il a réussi !

Les pratiques de nombreux référenceurs ont évolué et sont en train d’évoluer. Globalement, il suffit de ne pas sur-optimiser aussi bien au niveau du contenu qu’au niveau des liens pour ne pas être touché. Les référenceurs qui optimisaient très peu les liens n’ont pas, par exemple, eu à changer leurs techniques.

Les budgets des annonceurs pourraient aussi se porter davantage sur des canaux moins périlleux que le SEO où rien ne peut être garanti, contrairement à… Google Adwords ! Le terrain est également dégagé pour imposer Google Shopping !

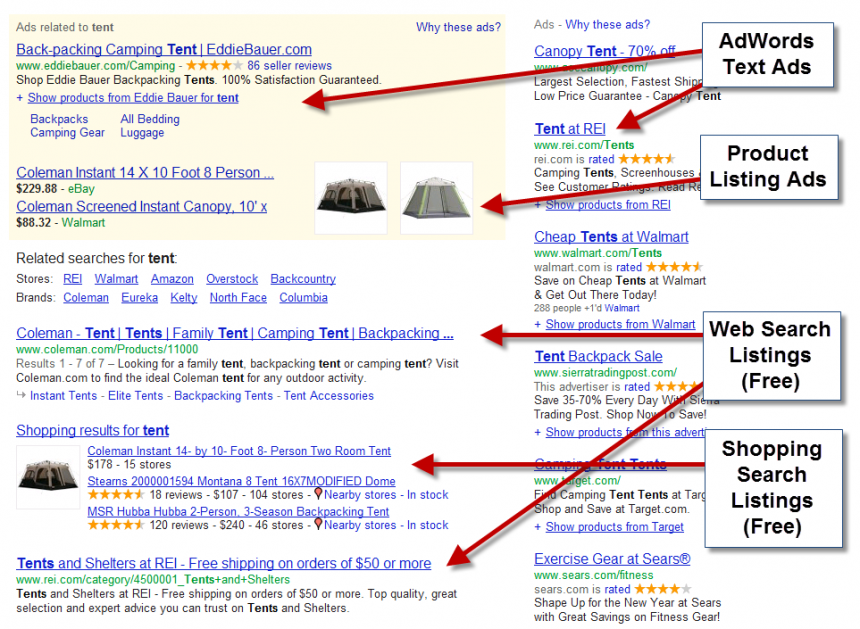

Quoi qu’il en soit, les référenceurs ont survécu à cette année difficile et le SEO n’est toujours pas mort. Il continue même de croitre. Voici ce à quoi pourrait ressembler les pages de résultats d’ici quelque temps :

D’un coup de baguette magique, plus aucun résultat naturel au-dessus de la ligne de flottaison, là où se concentrent le maximum de clics !

De quoi faire baisser drastiquement le ROI extraordinaire du canal SEO.

Les EMD

En septembre est sortie une autre mise à jour visant à réduire la visibilité des noms de domaine contenant des mots clés : les EMD (exact match domain).

Voici un exemple fictif : freelance-integrateur-pas-cher.fr.

Comme vous le savez certainement, les mots clés présents dans un nom de domaine sont un critère pris en compte par Google dans ses algorithmes, surtout qu’il y a eu de nombreux ajustements depuis.

De mon coté, j’ai vu plusieurs EMD passer de la position 1 à 4, et dans le même temps d’autres remonter. Difficile de conclure.

Par ailleurs, il est vrai que de nombreux EMD sont tenus par des spécialistes du web (référenceurs, affiliés, etc.) qui produisent parfois des sites à faible valeur ajoutée dans un souci de monétisation rapide. Stratégie opposée à celle de la création d’une belle et pérenne marque susceptible d’investir dans Google Adwords.

Knowledge Graph

Le 5 décembre dernier est sorti en France le « Knowledge Graph » (plus de six mois après les USA). L’objectif officiel de Google est d’être plus pertinent pour les mots clés pouvant posséder plusieurs sens (apple, jaguar, etc.) et surtout de donner directement encore plus d’informations aux internautes.

Tapez « beyoncé » ou « tour eiffel » et observez la mine d’informations proposée dans la colonne de droite. Cela fonctionne très bien avec notamment toutes les entités nommées.

Pour arriver à cela, Google a notamment racheté la société Metaweb qui possédait un nombre de données très important. Google annonce aujourd’hui avoir identifié plus de 500 millions d’entités et plus de 15 milliards de relations.

Des réponses aux questions sont donc affichées directement, il devient parfois inutile de cliquer, il suffit de rester sur Google. Vous avez compris ?

L’impact pour le trafic naturel d’un site web est évident. Bien entendu, comme avec chaque nouveauté, il est possible d’y voir des avantages et d’essayer d’exploiter favorablement le Knowledge Graph, par exemple via Google Images…

Quoi qu’il en soit, cela réduit encore la part de visibilité des résultats naturels.

L’avenir du SEO ?

Non, le SEO n’est pas mort. Les budgets ne cessent d’augmenter, même.

Il est évident que Google souhaite s’affranchir au maximum des critères triviaux et facilement spammables : noms de domaine, mots clés dans les URL, indice de densité, balises meta keywords…

L’avenir du SEO réside donc dans l’optimisation de nouveaux critères.

Il n’y a pas encore assez d’utilisateurs sur Google+ pour que Google pondère fortement les critères émanant de ce support, mais on y viendra…

Globalement, Google essaye d’évaluer constamment la pertinence de ses résultats et donc la satisfaction des utilisateurs. Il faut alors chercher à simuler la satisfaction.

Un internaute qui reste longtemps sur un site, qui visite plusieurs pages, qui y retourne fréquemment, qui le recommande, qui ne retourne pas sur le moteur pour visiter et rester sur les autres sites proposés… Voilà quelques pistes de réflexion.

Impossible d’obtenir ces informations pour Google ?

Pensez à Google Analytics, à la Google Toolbar, à Google Chrome, aux cookies de DoubleClick, à Android, à Google Url Shortener, à Google Plus, à Gmail…

« Google is watching You, Don’t be evil » qu’il disait…

17 commentaires sur cet article

TOMHTML, le 21 décembre 2012 à 1:25

Ces campagnes de menaces anti-SEO (Panda, Pingouin) sont une preuve flagrante de l'échec de Google face aux spammeurs et autres black hat SEO.

Il suffit de regarder les vidéos de Matt Cutts, où il ne répond plus que part "il suffit de suivre les règles, c'est le bien", pour se rendre compte à quel point ils sont en position de faiblesse. Ça se sent depuis un peu plus d'un an maintenant, c'est de pire en pire. La pression financière derrière pour monétiser tout ce que peux faire l'internaute ne permet pas d'apaiser ce climat....

Bon courage pour la suite !

LaurentB, le 21 décembre 2012 à 7:56

Amen!

Voilà la situation rondement bien résumée.

Il faudra juste mettre à jour l'image des SERPS, car GG Shopping va passer en mode payant.

Fealk, le 21 décembre 2012 à 13:48

Ouh que c'est bien dit tout çà,

Bon c'est sûr, GG durcit le ton mais ne fait-on pas de SEO aussi pour le challenge ? Tout a fait d'accord avec toi sur ta conclusion, l'utilisateur ou le client doit être au centre de nos attentions, le "faire savoir" de sa satisfaction sera un élément clef.

François-Olivier, le 21 décembre 2012 à 15:20

Super article. Par contre tu parles d'une situation de ecommerce. Dis toi que opur un SEO sur du portail de contenu ou des comparateur, ces 12 derniers mois ont été ... extrêmement durs.

C'est tout un modèle économique qui a du être repensé pour ces acteurs.

Mikiweb, le 21 décembre 2012 à 15:43

Bon résumé sur l'évolution de Google et des conséquences pour le référencement des sites.

J'ai l'impression que cette année à été la plus riche en rebondissement de tout l'an 2000. J'ai dû repenser ma stratégie d'acquisition de lien qui n'offrait plus les même résultats qu'il y a quelques années.

Mais c'est aussi pour ça que j'aime le référencement, ça bouge tout le temps, faut tester et retester, trouver des pépites pour les exploiter, c'est un challenge de tous les jours et c'est bien cela qui me fait me levé tout les matins ;)

37°2, le 21 décembre 2012 à 15:44

Ce qui me plait c'est surtout le bruit que font les modifications de google. Ensuite comme tu dis plus haut il s'attaque surtout au petit malin qui font du contenu pour les moteurs de recherche. Personnellement je n'ai pas constaté beaucoup de changement dans les classement. Continuons de construire des sites pour l'humain et non pas pour la machine et tout devrait aller bien.

Florence - Mamie du Référencement, le 21 décembre 2012 à 17:01

Oui, comme le signale Laurent, l'image des SERPs ne ressemblera pas à ça, d'autant moins avec le knowledge graph qui va occuper la sidebar qui affichait jusque-là des AdWords.

Penguin a touché peu de cibles (2% de notre parc de sites) mais les a touchés durement et paradoxalement, malgré un contenu d'excellente qualité alors que dans le même temps nous avons vu parader en haut de la 1ère page des sites satellites nourris aux textes malgaches ou des sites en Flash. C'est ce qui me fait sourire lorsque je vois fanfaronner ceux qui n'ont pas été touchés et qui prétendent que c'est dû à la qualité de leurs sites ou de leurs techniques...

Je fais du référencement depuis 2002 - 2003, j'ai aujourd'hui une équipe de 5 référenceurs in-house et en 10 ans de métier nous n'avions, les uns comme les autres, jamais traversé une année aussi difficile pour référencer de nouveaux sites. Pour les anciens sites, tout va super bien, heureusement, c'est surtout pour positionner de nouveaux sites que c'est devenu bien plus chaud...et il suffit d'en discuter avec d'autres référenceurs pour comprendre que nous ne sommes, -et de loin-, pas les seuls à le constater !

Le Juge, le 21 décembre 2012 à 19:21

Bien bon ce petit retour sur "un peu plus" que l'année 2012 au final mais qui résume bien les evenements majeurs de la communauté. Je vais faire mon petit retour moi aussi mais ce sera plus "personnel" - tres bon en tout cas

CapitaineSEO, le 21 décembre 2012 à 19:47

beau résumé de cette année et demi. Il y a eu effectivement beaucoup de changements et certains ont pu être décourager mais le SEO a encore un bel avenir. Les propriétaires de sites et les propriétaires de boutiques en ligne voient bien l'intérêt d'un bon positionnement dans Google. Même si Aurélien le montre bien, les résultats naturels sont poussés vers le bas de la page et peuvent ne plus apparaître au dessus de la ligne de flottaison.

Julie, le 21 décembre 2012 à 23:41

J'ai l'impression que beaucoup de petite boutique avec du BL sur les fiches produits sont tombé cette année, effectivement ca pique beaucoup de voir son trafic chuter de 70% du jour au lendemain

Arnaud, le 22 décembre 2012 à 12:15

Tout est dit! Et même si Google cherche à faire peur, l a arrive fatalement à décourager certains, mais il rend surtout les autres plus forts. Une des grandes qualités du SEO, c'est d'être ingénieux alors il y aura toujours des solutions...

Phil, le 22 décembre 2012 à 12:29

C'est bien çà le problème comme le dit Florence, les sites anciens sont bien au chaud au coin du feu et les nouveaux sites se les gèlent dehors sous la neige .

Il est de plus en plus dur de faire comprendre à GG qu'il peut avoir confiance dans les nouveaux sites ...

meduseo, le 24 décembre 2012 à 13:13

Je ne suis pas du tout d'accord avec ceci :"L'objectif de Google n'était pas de modifier énormément ses résultats, qui sont globalement très pertinents..."

Il y a de moins en moins de pertinence selon moi et des tonnes de paradoxes dans les serp.

Si google continue a n'avoir qu'une augmentation de CA comme objectif, sans se soucier de l'experience utilisateur (un comble quand meme!), il naitra certainement un jour un moteur de recherche alternatif.

Enfin, c'est mon souhait :)

loran, le 29 décembre 2012 à 21:39

Cela montre une chose certaine : Google laisse de moins en moins de place aux référenceurs et les a directement dans son viseur.

"Tremblez, vils SEO, tremblez et rentrer dans les rangs, tels que définis dans les guidelines de Google.

Transgressez une de ces directives, franchissez la ligne jaune et je vous déclasserai directement" prévient Matt Cutts.

Certes, Google s'est grandement amélioré mais c'est aussi aux référenceurs de réfléchir à créer des sites, trouver des plans qui semblent naturels.

Oui, c'est plus difficile qu'avant.

Aurélien, le 11 janvier 2013 à 16:55

Merci à tous pour vos commentaires pertinents et remarques.

Hervé Augoyat, le 19 septembre 2013 à 15:49

Disons que ces changements assez importants avec Panda et Penguin vont plutôt dans le bon sens selon moi. Cela pousse le référenceur de site internet à renouveler ses techniques, à prendre en compte l'internaute avant tout, à mieux se focaliser sur le contenu proposé, ce qui est plutôt bien.

Le problème, c'est qu'il y a systématiquement des exceptions. Des sites sont pénalisés pour des actions très mineures, parfois involontaires, tandis que d'autres restent invulnérables malgré des actions pourtant clairement agressives associées à de mauvaises pratiques et contraire aux recommandations de Matt Cutts... C'est ce qui pose le doute et apporte beaucoup de confusion dans la démarche de référencement natruelle...

Developpeur Web Paris, le 3 mai 2018 à 8:21

Super Article ! Vraiment très instructif... :)

Il n’est plus possible de laisser un commentaire sur les articles mais la discussion continue sur les réseaux sociaux :